- Published on

机器学习中的向量化是什么?

- Authors

- Name

- Jason Huang

- @zesenhhh

向量化是什么?

简单理解向量化就是将复杂数据(如图片或文字)转化为数字列表(向量)的方法。

向量化(Vectorization)是机器学习和深度学习的基础,算法模型处理的永远是数字,之所以能处理文本与图片,就是通过向量化将其转成了数字。

以“我爱吃苹果”这句话来举个简单例子:

假设我们要把它变成电脑能理解的数字向量。一个简单的方法是给每个字或词分配一个数字表示它的意思或特征。比如,

我们简单地给每个字随机分配一个数字:

- “我”:0.3

- “爱”:0.7

- “吃”:0.2

- “苹果”:0.9

于是,“我爱吃苹果”可以被向量化成一个数字列表:[0.3, 0.7, 0.2, 0.9]。这个数字列表就是这句话的数字形式,也就是这句话的向量。不过,在现实中,向量化并不是随便随机给数字的,而是通过一些复杂的方法(比如统计学习或神经网络词嵌入技术)计算出来的。

向量化后能做什么?

文本在向量化后我们得到了向量,相似性计算是向量化后的重要运用。

上述“我爱吃苹果”这句话的向量是随便给的,没什么特别的意义,但是实际的向量远比 [0.3, 0.7, 0.2, 0.9] 这个例子复杂得多,并且实际上文本向量化后的向量是有意义的,它是带有语义信息的,这个信息具有重大意义,主要体现在:

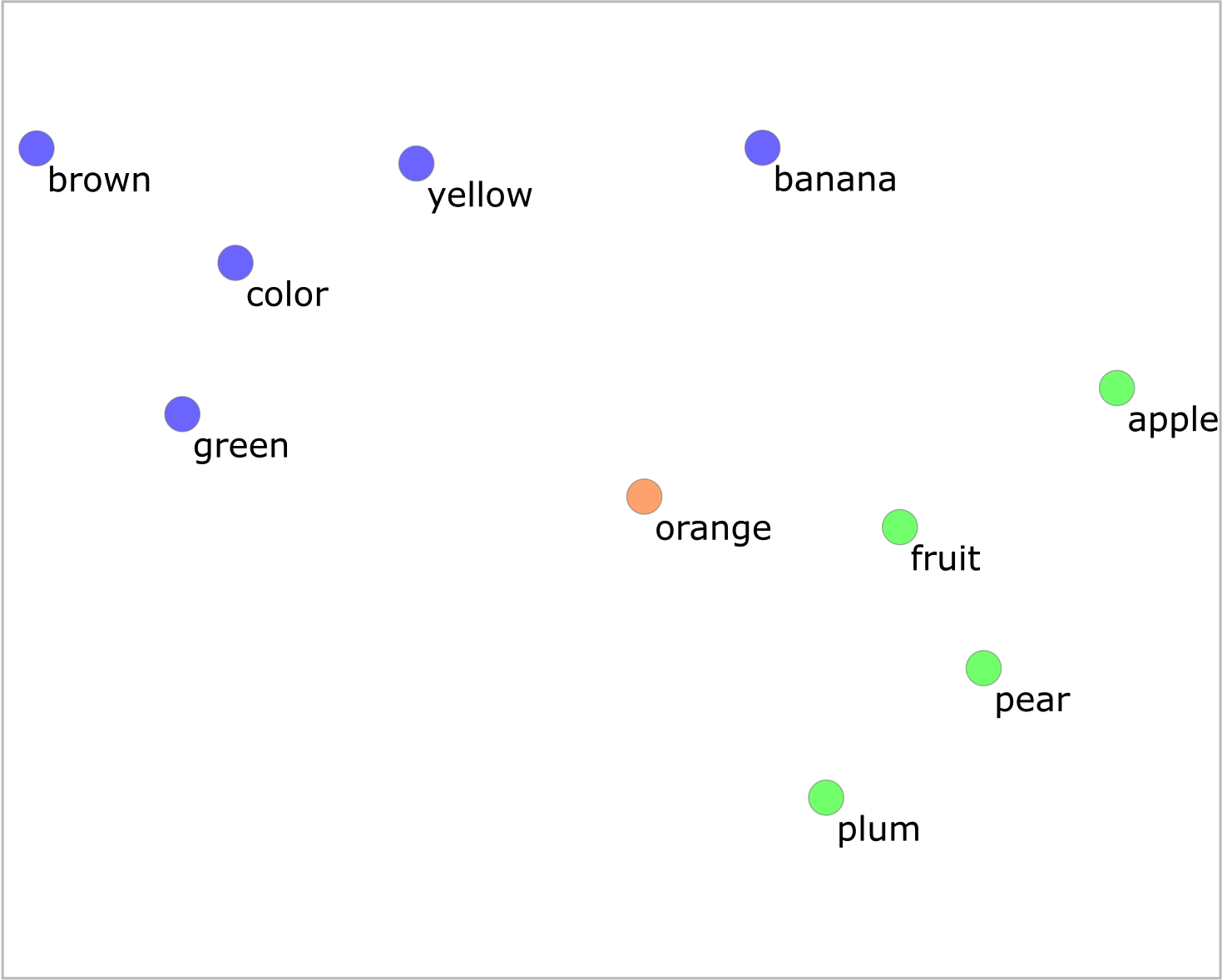

1.在数学空间中,相似的词的向量彼此离得更近,如下图;  2.向量可以用来做加减乘除等运算,最常用的是算 cosine,也就是计算余弦相似性(Cosine Similarity)。

2.向量可以用来做加减乘除等运算,最常用的是算 cosine,也就是计算余弦相似性(Cosine Similarity)。

神经网络模型产生的向量的运算可以揭示类似这样的语义关系:

“king” - “man” + “woman” ≈ “queen”。

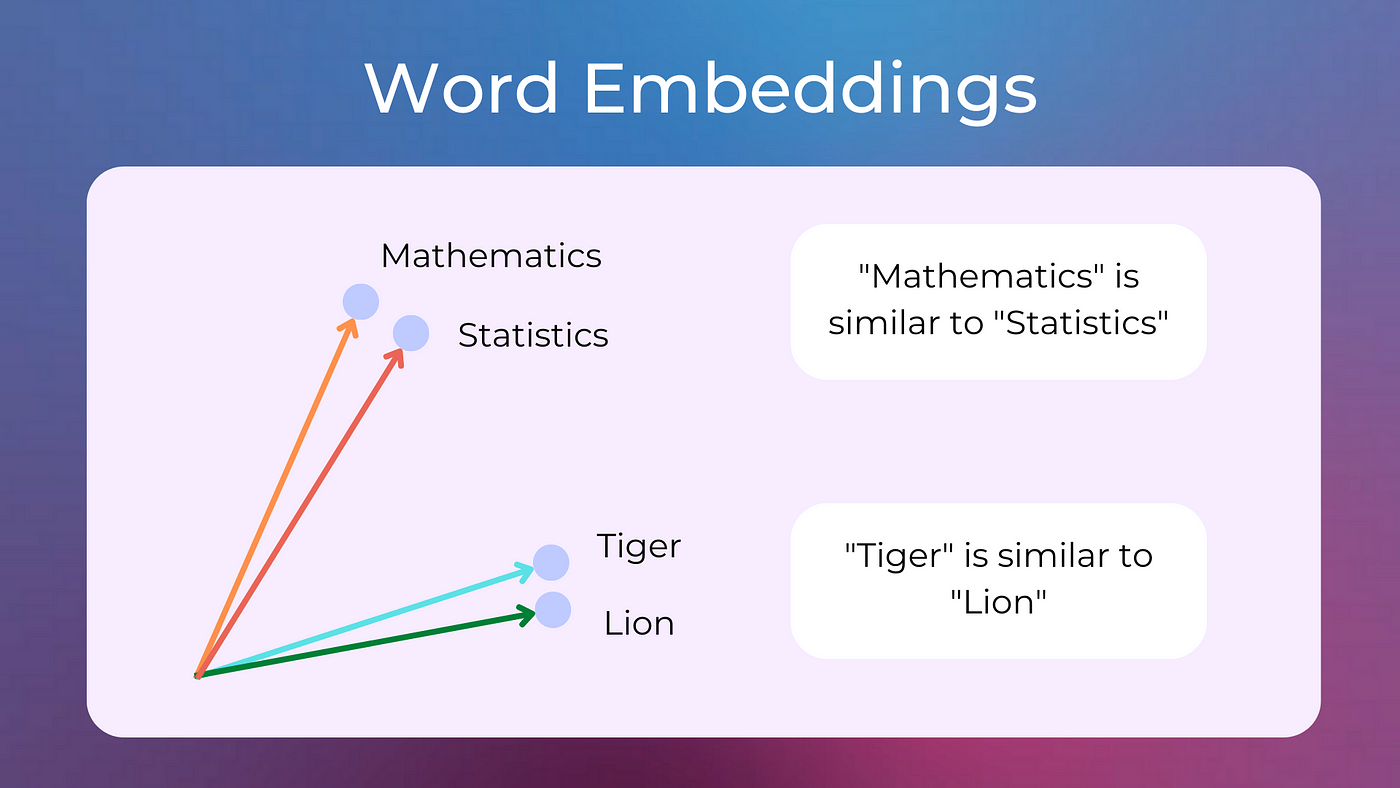

相似性计算也就是使用余弦相似性衡量两个向量之间有多相似,如下图:  余弦相似度衡量的是多维空间中两个向量方向的相似程度。它不考虑向量的大小,只关注它们的方向:方向越接近,相似度越高;互相垂直则表示毫不相似;方向相反则表示负相关。

余弦相似度衡量的是多维空间中两个向量方向的相似程度。它不考虑向量的大小,只关注它们的方向:方向越接近,相似度越高;互相垂直则表示毫不相似;方向相反则表示负相关。

实际能有哪些应用?

引用王喆《深度学习推荐系统》这本书的原文:

Embedding,中文直译为“嵌入” ,常被翻译为“向量化”或者“向量映射” 。在整个深度学习框架中,特别是以推荐、广告、搜索为核心的互联网领域,Embedding 技术的应用非常广泛,将其称为深度学习的“基础核心操作”也不为过。

之前的章节曾多次提及 Embedding 操作,它的主要作用是将稀疏向量转换成稠密向量,便于上层深度神经网络处理。事实上,Embedding 技术的作用远不止于此,它的应用场景非常多元化,而且实现方法也各不相同。

在学术界,Embedding 本身作为深度学习研究领域的热门方向,经历了从处理序列样本,到处理图样本,再到处理异构的多特征样本的快速进化过程。在工业界,Embedding 技术凭借其综合信息的能力强、易于上线部署的特点,几乎成了应用最广泛的深度学习技术。

因为向量化能够将文本、图片等非结构化数据转化为包含深层语义信息的数值表示,基于向量相似性计算,不仅可以实现精准的内容关联,还能支撑多种搜索与推荐算法。

向量化是许多搜索与推荐算法模型的基础。无论是基于协同过滤的推荐系统,还是基于深度学习的语义搜索模型,都需要依赖高质量的向量化结果作为输入。通过向量化,非结构化数据和离散数据得以融入算法模型的框架,为内容分发和用户交互提供了强有力的技术支持。因此,向量化不仅是技术实现的关键步骤,更是提升用户体验的重要手段。

现代搜索、推荐和广告系统的底层技术是类似且可相互迁移的,绝大部分都是混合传统方法与向量化+深度学习模型的,技术已经很成熟了,其中的个性化与智能化大部分来自算法与模型。像电商的商品推荐,内容平台的文章与视频推荐等;至于搜索,除了传统的关键词匹配外,语义搜索和图片搜索基本都是基于向量的,这也是现在 AI 搜索(RAG)检索环节的基础。